感情モデル

一般に「ロボット」は心つまり感情のない存在と考えられています。

しかし、ロボットが人間社会に受け入れられていくためには、相手の感情を理解・共感し、行動するということが必要です。

本研究では、人とロボットが共感し合う未来を目指して感情モデルの研究を行っています。

感情モデルを作ることを通して、人の感情のメカニズムを明らかにするとともに、ロボットに感情モデルを実装し、人を理解し自身の感情を表出する人工物を開発します。

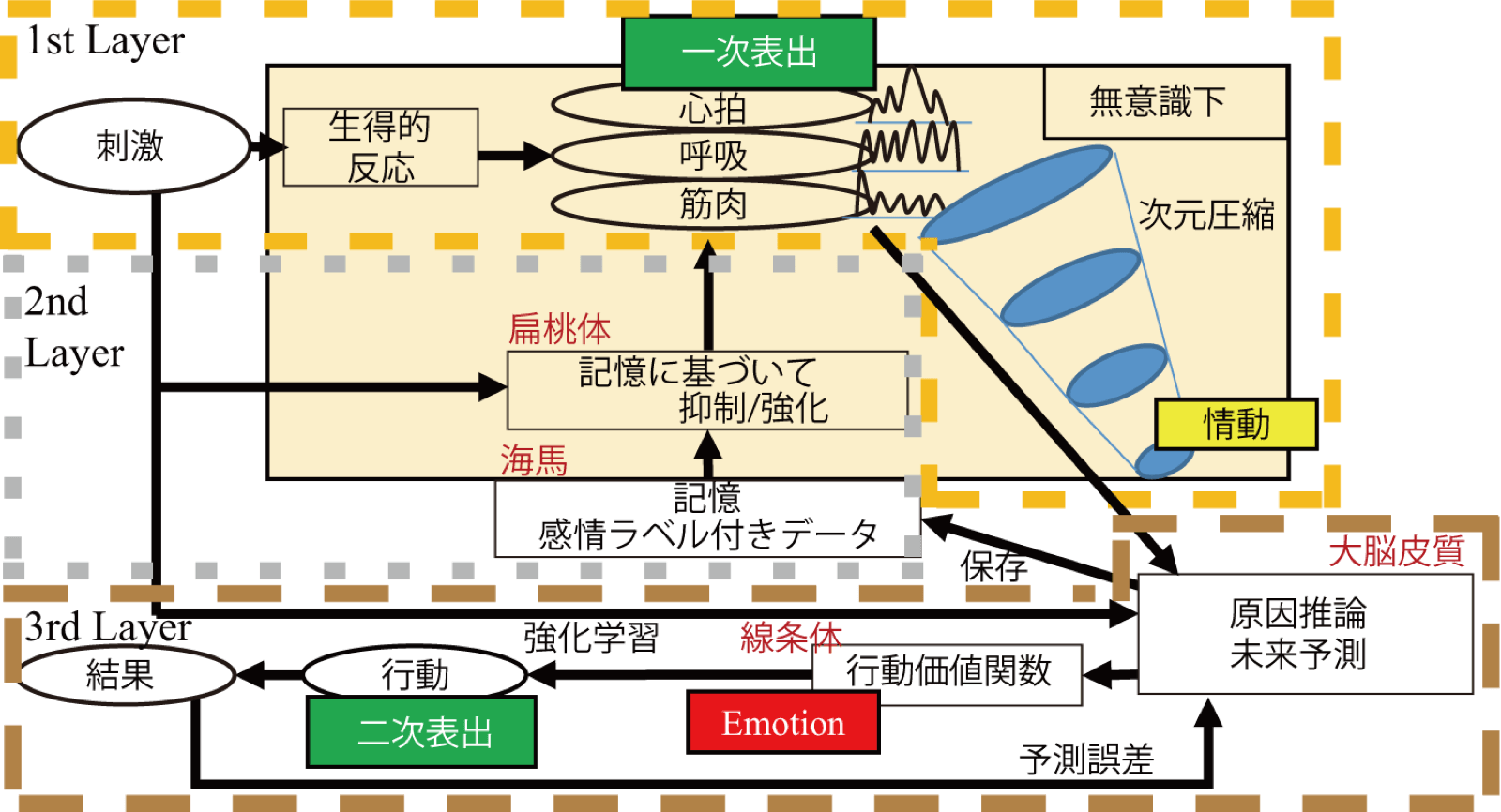

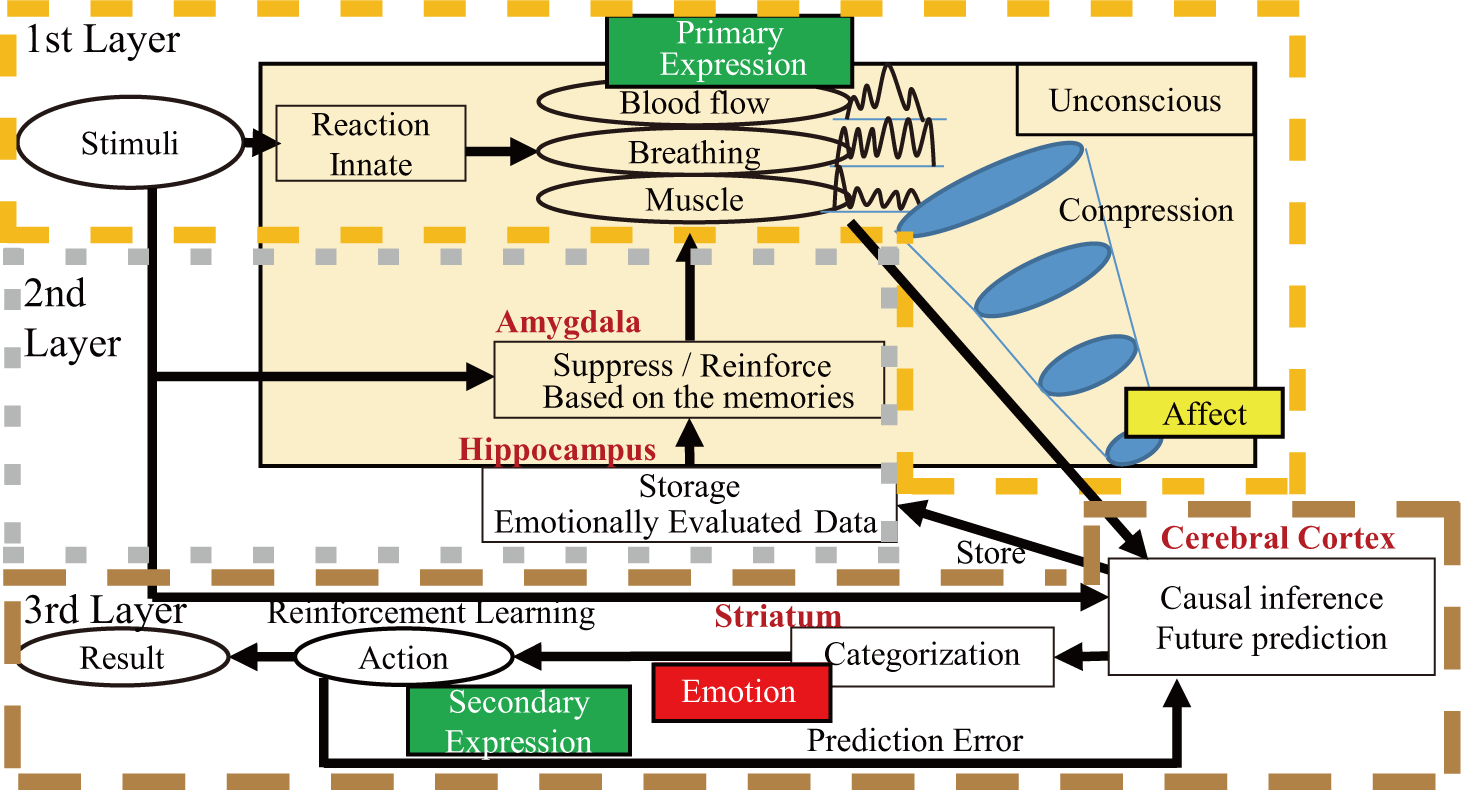

提案している感情モデルは以下の三層に分かれています。

- 第1 層:生得的反応層

刺激を受け、身体的反応を行う - 第2 層:経験層

刺激を受け、経験に基づいて生得的反応を抑制・強化する - 第3 層:予測層

次元圧縮された身体的反応(情動)と刺激に基づいて、原因推論・未来予測を行う

第1層は反射的に反応する層であり、時間的に処理が最も早いですが、エラーも多くなります。それに対し、第2層では過去の記憶にアクセスするため、第1層からの遅延がありますが、経験に基づいて評価するため、エラーを減らすことができます。この第1層、第2層から出力された一次表出を次元圧縮したものが情動であると定義しています。

こうして得られた情動と入力信号を使って原因推論をし、未来予測を行います。未来予測の結果を使って最適な行動を出力します。このときの情報がカテゴリとして意識へと昇ったものが感情として認知されます。

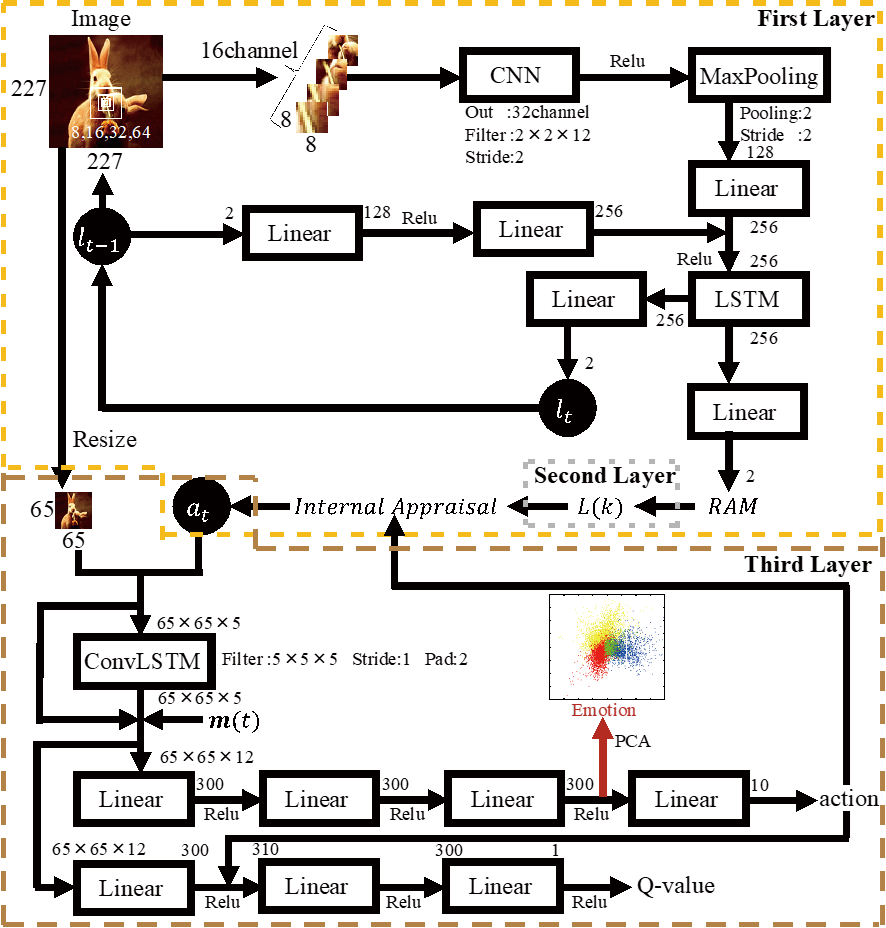

下記の図が実装したネットワークです。

第1層の実装では、Recurrent Attention Modelというvisual attentionを含んだRecurrent Neural Networkを用いて画像刺激から情動値を出すネットワークを構築しています。

学習にはInternational Affective Picture Systemを用いています。

このネットワークをロボットに実装し、実際にコミュニケーションをした結果、見せたものによって好みを表出したり、情動伝染のような反応を見せました。

第2層の実装ではsmoothingのsystemを導入し、第3層ではconvolutional LSTM とDeep Deterministic Policy Gradient(DDPG)を組み合わせて実装しています。

この実装の詳細は論文「Deep Emotion」をご参照ください。全体を実装したモデルを使用して、母子インタラクションを模したタスクでシミュレーションを行いました。

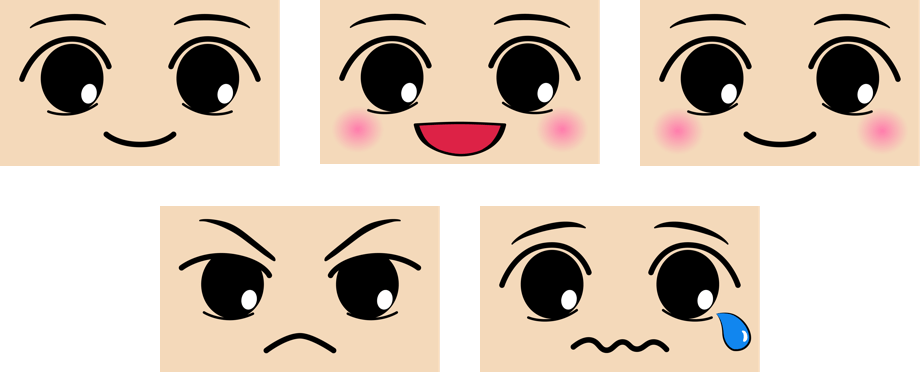

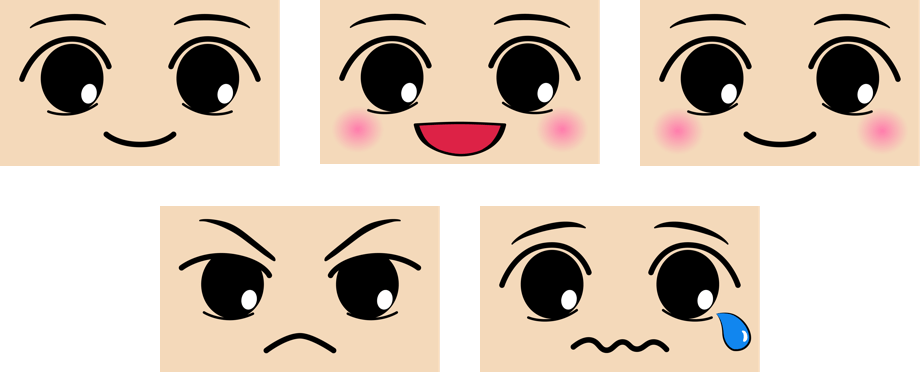

モデルへの入力は母親役の顔画像、出力は子どもの連続的な子どもの表情です。母親役の顔画像は子どもの表情を模倣したものを入力することになっています。

学習はホメオスタシス(恒常性)を基準に行われます。具体的には自分の情動反応(今回は第一層の出力にAgentの体力パラメータを合わせたもの)を一定に保つように行動を選択します。

つまり、子どもはホメオスタシスの観点から自分の欲しい入力を得るために表情をかえることになります。

下記は学習したAgentの挙動です。

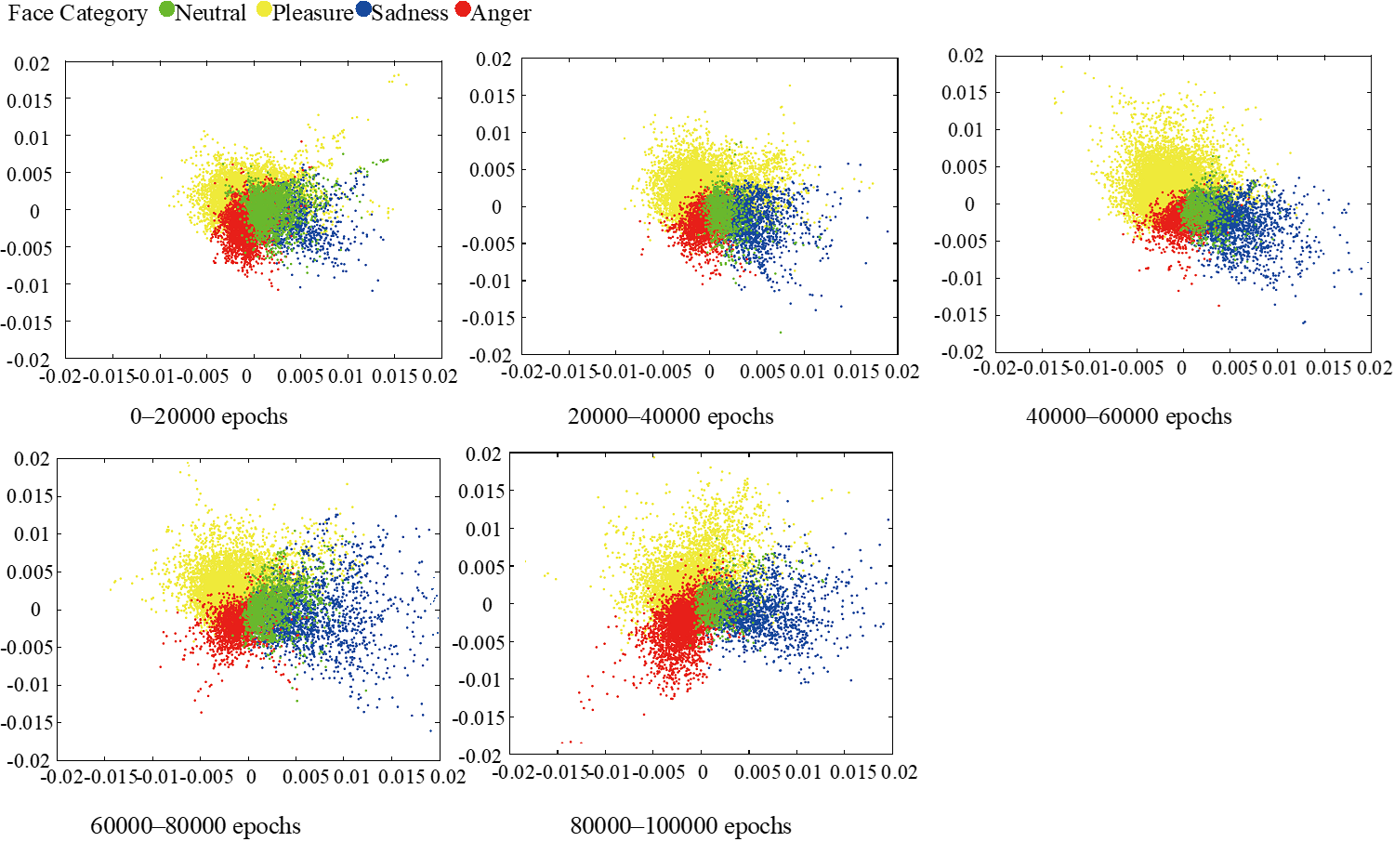

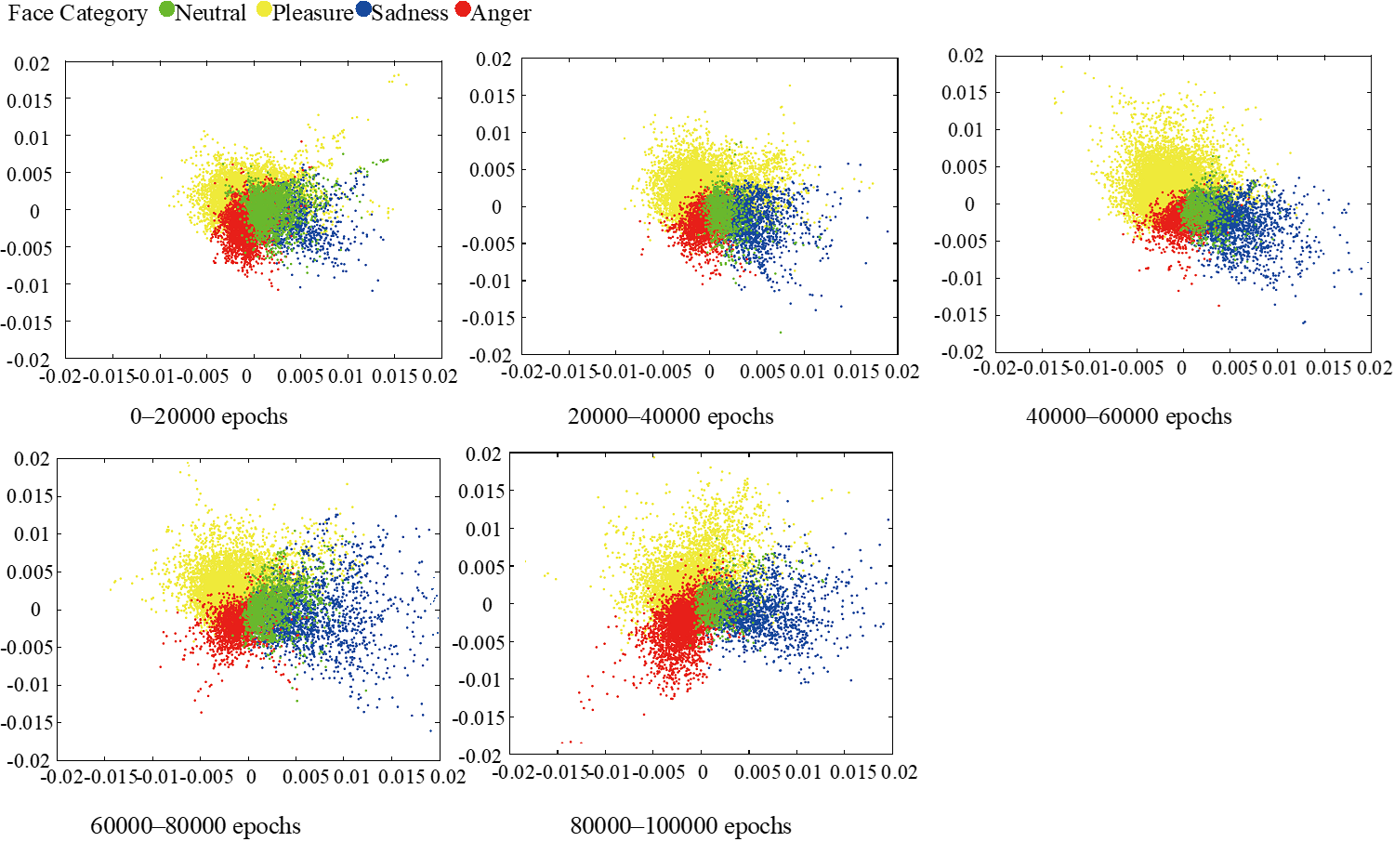

本AgentのDDPGのPolicy networkの中間層をPCAで可視化すると、下記のような図が得られます。

この図の色分けは母親役が模倣するときに認識している子どもの表情のカテゴリとなっていますが、この空間内では各カテゴリが徐々に分化していっていることがわかります。

これは各カテゴリの行動を使い分けているということになりますが、行動をみた親から言語情報を与えられることによって、怒りや悲しみなどといったカテゴリカルな感情を獲得すると考えており(記号接地)、

即ちこの空間が感情分化を表現していると考えています。

今後はモデルでの認知科学的実験結果の実証などを通して、モデルの妥当性とそのメカニズムをより深く理解することを目指しています。

業績:

Hieida, Chie, and Takayuki Nagai. "Survey and Perspective on Social Emotions in Robotics." Advanced Robotics DOI:10.1080/01691864.2021.2012512 (2022).

Hieida, Chie, and Takayuki Nagai. "Survey and Perspective on Social Emotions in Robotics." arXiv preprint arXiv:2105.09647 (2021).

日永田智絵. "Deep Emotion: 感情理解へ向けた深層感情モデルの開発." 人工知能 36.1 (2021): 43-50.

Hieida, Chie, Takato Horii, and Takayuki Nagai. "Deep emotion: A computational model of emotion using deep neural networks." arXiv preprint arXiv:1808.08447 (2018).

Emotion Model

Most people believe that robots have no emotions, and nor do they need them. However, we strongly believe that having emotions is essential for robots to understand and sympathize with the feelings of people, thereby allowing them to be accepted into the human society.

In this research, we propose a model of robot emotions based on some neurological and psychological findings in the literature to achieve empathic communication between humans and robots.

This research is indispensable not only to build robots with emotions, but also to make them truly understand the human mental state.

The proposed emotion model is illustrated below.

-

1st Layer: Hardwired Innate System

The first layer can react bodily to stimuli very fast. -

2nd Layer: Experience System

The second layer is able to access memories such that stimuli can be evaluated through experiences. -

3rd Layer: Prediction System

The affect, which is the output from the first and second layers, is used together with the input stimuli for causal inference and prediction. Then, the information is grouped into emotional categories that are consciously recognized as emotions.

The implementation is shown in the following figure.

As a first step toward realizing the proposed emotion model, we examine affect generation from visual stimuli using a recurrent attention model.

In order to replicate the innate reactions, we utilize the International Affective Picture System (IAPS) to train the network to output two-dimensional values, i.e., valence and arousal, for a given visual stimulus (24,200 images for training and 100 for testing).

I implemented this network on a robot, and human subjects communicated with the robot. As a result, the robot expressed preferences, and the emotional contagion occurred from subjects to the robot.

The second layer is implemented by the smoothing system, and the third layer is implemented by combining the convolutional LSTM and the Deep Deterministic Policy Gradient (DDPG).

Please refer to the paper "Deep Emotion" for the details of this implementation. The simulation was performed with a task that simulates mother-infant interaction, using the model implemented as a whole.

The input to the model is the mother's face image, and the output is the child's continuous child's expression. The face image of the mother role is to input what imitates the child's expression.

Learning is based on homeostasis. Specifically, the action is selected so as to keep constant your emotional response (this time, the output of the first layer plus the physical strength parameter of Agent).

In other words, children change their expression to get the input they want from a homeostasis point of view.

The following is the behavior of the learned Agent.

When the middle layer of DDPG's Policy network of this Agent is visualized by PCA, the following figure is obtained.

The color coding in this figure is the category of the facial expression of the child that is recognized when the mother role imitates, and it can be seen that in this space each category is gradually differentiated.

This means that the action of each category is used properly. I think that children can acquire categorical emotions such as anger and sadness by being given verbal information from parents who see their behavior (sign grounding), that is, this space expresses emotional differentiation I think.

In the future, I aim to further understand the validity of the model and its mechanism through the demonstration of experimental results of cognitive science in the model.

PUBLICATION:

Hieida, Chie, and Takayuki Nagai. "Survey and Perspective on Social Emotions in Robotics." Advanced Robotics DOI:10.1080/01691864.2021.2012512 (2022).

Hieida, Chie, and Takayuki Nagai. "Survey and Perspective on Social Emotions in Robotics." arXiv preprint arXiv:2105.09647 (2021).

日永田智絵. "Deep Emotion: 感情理解へ向けた深層感情モデルの開発." 人工知能 36.1 (2021): 43-50.

Hieida, Chie, Takato Horii, and Takayuki Nagai. "Deep emotion: A computational model of emotion using deep neural networks." arXiv preprint arXiv:1808.08447 (2018).